robot.txt是干嘛的,robot.txt的規范寫法是怎樣?s

導讀:seo動態seo動態 大家好,今天小編要給大家分享的是robot.txt是干嘛的,robot.txt的規范寫法是怎樣?,對于這個,啟明seo非常認可,所以做個分享,希望能夠對大家有網站推廣優化seo網站建設制作。

大家好,今天小編要給大家分享的是robot.txt是干嘛的,robot.txt的規范寫法是怎樣?,對于這個,SEOUCseo非常認可,所以做個分享,希望能夠對大家有所幫助。

作為一名站長,檢查網站日志是非常有必要的工作,通過日志我們可以知道蜘蛛抓取了哪些頁面,通常我們會發現搜索引擎喜歡抓取動態的鏈接,那么我們可以通過robot.txt去屏蔽掉,不讓它抓取,從而提升蜘蛛抓取效率,那么robot.txt是干嘛的,robot.txt的規范寫法又是怎樣呢?

?robot.txt是干嘛的?

?robots協議也叫robots.txt(統一小寫)是一企業網站建設種存放于網站根目錄下的ASCII編碼的文本文件,它通常告訴網絡搜索引擎的漫游器(又稱網絡蜘蛛),此網站中的哪些內容是不應被搜索引擎的漫游器獲取的,哪些是可以被漫游器獲取的。因為一些系統中的URL是大小寫敏感的,所以robots.txt的文件名應統一為小寫。robots.txt應放置于網站的根目錄下。如果想單獨定義搜索引擎的漫游器訪問子目錄時的行為,那么可以將自定的設置合并到根目錄下的robots.txt,或者使用robots元數據(Metadata,又稱元數據)。

?簡單來說說,網站的根目錄需要放置一個txt文件,這個文件以robots命名,它是告訴搜索引擎我們網站上哪些頁面可以抓取,哪些頁面禁止抓取,從而提高搜索引擎的判斷能力,同時搜索引擎也會遵循這一協議,雙方各取所需。

robot.txt原則:

?Robots協議是國際互聯網界通行的道德規范,基于以下原則建立:

?1、搜索技術應服務于人類,同時尊重信息提供者的意愿,并維護其隱私權;

?2、網站有義務保護其使用者的個人信息和隱私不被侵犯。

?robot.txt的規范寫法:

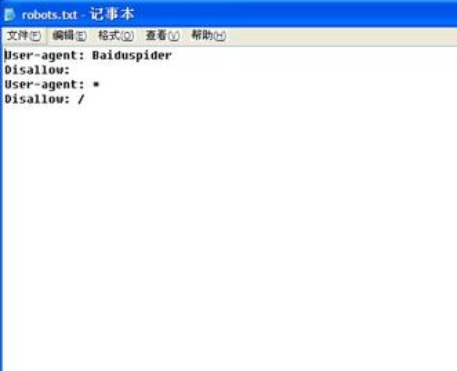

?例1. 禁止所有搜索引擎訪問網站的任何部分

?User-agent: *

?Disallow: /

?禁止所有搜索引擎顯然不符合我們的目的,一般在網站上線前可以禁止抓取,這樣做是不讓搜索引擎蜘蛛來抓取的時候網站是空的,而正常情況下我們只需要屏蔽掉一些不好的鏈接,比如動態鏈接,圖片目錄等就好。

?例如:

?User-agent: *

?Disallow: /plus/ad_js.php

?Disallow: /plus/advancedsearch.php

?Disallow: /plus/car.php

?聲明: 本文由我的SEOUC技術文章主頁發布于:2023-06-22 ,文章robot.txt是干嘛的,robot.txt的規范寫法是怎樣?s主要講述是怎樣,寫法,seo動態網站建設源碼以及服務器配置搭建相關技術文章。轉載請保留鏈接: http://www.bifwcx.com/article/seo_17119.html

- 上一篇:SEO優化方法seo實戰

- 下一篇:SEO應用場景介紹及成功案例分析SEO基礎